In futuro, Nvidia vuole offrire il doppio degli acceleratori di calcolo GPU rispetto a prima. I modelli migliori non dovrebbero più essere rilasciati ogni due anni, ma ogni anno. Anche le schede grafiche per giochi possono trarre vantaggio da cicli ridotti.

annuncio

Dalla generazione Volta, Nvidia ha diviso lo sviluppo tra schede grafiche gaming e acceleratori GPU per server: l’esclusiva V100 per server è stata rilasciata nel 2018, seguita dall’A100 nel 2020 e dall’H100 nel 2022.

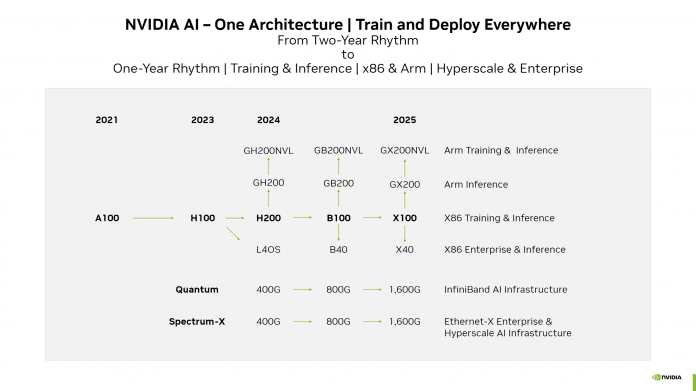

Come parte di a In una presentazione per gli investitori, Nvidia ha recentemente pubblicato una tabella di marcia per la GPUt, che indica il nuovo ritmo annuale. La generazione Blackwell emergerà l’anno prossimo, guidata dal B100. Il passaggio ad architetture GPU aggiuntive inizierà nel 2025. Nvidia chiama il modello di punta “X100”, presumibilmente come prefisso segnaposto.

Roadmap GPU di Nvidia per acceleratori di calcolo. Sia l’A100 che l’H100 verranno introdotti con un anno di ritardo, forse perché da allora l’azienda è stata in grado di spedire quantità maggiori.

(Immagine: Nvidia)

Sono possibili altri modelli GeForce di fascia alta

Inoltre, Nvidia vuole portare nuove schede grafiche ai clienti aziendali con B40 e “X40” e implementare algoritmi AI completamente addestrati (euristica). I rami precedenti di questa categoria utilizzano GPU che Nvidia utilizza anche nei suoi modelli GeForce di punta. Ad esempio, la nuova L40S e la GeForce RTX 4090 condividono la GPU AD102, mentre la A40 e la GeForce RTX 3090 (Ti) condividono la GPU GA102.

Queste varianti finora hanno utilizzato GDDR invece della RAM HBM e sono progettate anche per il calcolo di immagini 3D. Se Nvidia manterrà questa divisione, è possibile che i nuovi modelli GeForce appariranno più frequentemente in futuro.

Molti altri modelli

Oltre al B100 e “X100”, ci sono le consuete derivazioni come GB200 e “GX200”, che combinano un acceleratore di calcolo con un processore ARM sviluppato internamente. Nvidia sta promuovendo versioni particolarmente ad alta capacità di NVL come leader per l’addestramento delle reti neurali.

Una nuova versione dell’H100, denominata H200, riduce i tempi di attesa per Blackwell. Come la scheda GH200 annunciata, probabilmente utilizzerà la RAM HBM3e invece della HBM3, con una velocità di trasferimento più elevata e una capacità maggiore.

Allo stesso tempo, l’azienda sta accelerando le sue interconnessioni e switch, che collegano molti server blade: nel 2024, la velocità di trasferimento raddoppierà fino a 800 Gbit/s, e nel 2025 dovrebbe raggiungere 1,6 Tbit/s.

I fondi per i corsi semplificati provengono principalmente dalle vendite di A100 e H100. Le aziende stanno letteralmente togliendo gli acceleratori GPU per l’addestramento all’intelligenza artificiale dalle mani di Nvidia. Le vendite trimestrali di Nvidia con queste GPU sono recentemente salite a oltre 10 miliardi di dollari e si prevede che continueranno a crescere, limitate solo dalle capacità di produzione e confezionamento del produttore di chip TSMC.

(MMA)

More Stories

Nissan Qashqai (2024): include un restyling

La concorrenza viene lasciata alle spalle: un’azienda familiare detronizza la Bayer dal trono farmaceutico

Il Fondo monetario internazionale abbassa le previsioni di crescita della Germania allo 0,2%.